News

Nahrung für Künstliche Intelligenz

Überblick von Trainingsdaten für die Bildanalyse in der Landwirtschaft

Autor: Florian Kitzler

Der Begriff der Künstlichen Intelligenz (KI) wird oft in unterschiedlichen Bedeutungen und Zusammenhängen verwendet. Ein Grund dafür ist eine fehlende eindeutige Definition von Intelligenz. Dies hat eine oftmals falsche Darstellung oder Vermengung mit anderen Begriffen zur Folge. Implementationen von KI sind Computerprogramme und Algorithmen, die versuchen kognitive Fähigkeiten des Menschen nachzuahmen, um damit intelligentes Verhalten zu automatisieren. Sie werden häufig zur Musteranalyse, Mustererkennung in Daten und in der Robotik verwendet. Eng damit verwandt ist der Begriff des Maschinellen Lernens (ML) als Teilgebiet der KI. Dabei geht es darum, Wissen aus Erfahrung zu generieren. Die hierbei verwendeten Algorithmen lernen selbstständig Muster in vorhandenen Daten zu erkennen. Beim sogenannten überwachten Lernen werden Modelle erzeugt und mithilfe von Erfahrung in Form von Trainingsdaten (Ground Truth Daten) parametriert. Nach diesem sogenannten Training wird das Modell auf neue Daten angewendet und das Ergebnis für eine Entscheidungsfindung herangezogen.

Abbildung 1: Versuch einer Annäherung an den Begriff Künstliche Intelligenz, Beispiele für Aufgaben und Methoden des Maschinellen Lernens und schematische Darstellung von Deep Learning Methoden.

Künstliche Neuronale Netze (KNN) mit einer Vielzahl von Zwischenebenen, sogenannte Deep Learning (DL) Modelle, werden vor allem im Bereich der Bildanalyse für folgende Aufgaben immer wichtiger.

- Klassifikation – Ein ganzes Bild wird einer Klasse zugeordnet

- Detektion – Objekte werden klassifiziert und im Bild lokalisiert

- Semantische Segmentation – Jedes Pixel wird einer Klasse zugeordnet

Deep Learning Modelle benötigen aufgrund ihrer großen Anzahl an Parameter in der Regel einen sehr großen Trainingsdatensatz. Die trainierten Modelle sind nicht mechanistisch, können also nicht durch eine Formel beschrieben werden. Man kann es eher mit einer Blackbox beschreiben bei der nicht klar nachvollziehbar ist was zwischen Eingabe und Ausgabe passiert.

Deep Learning Anwendung in der Landwirtschaft

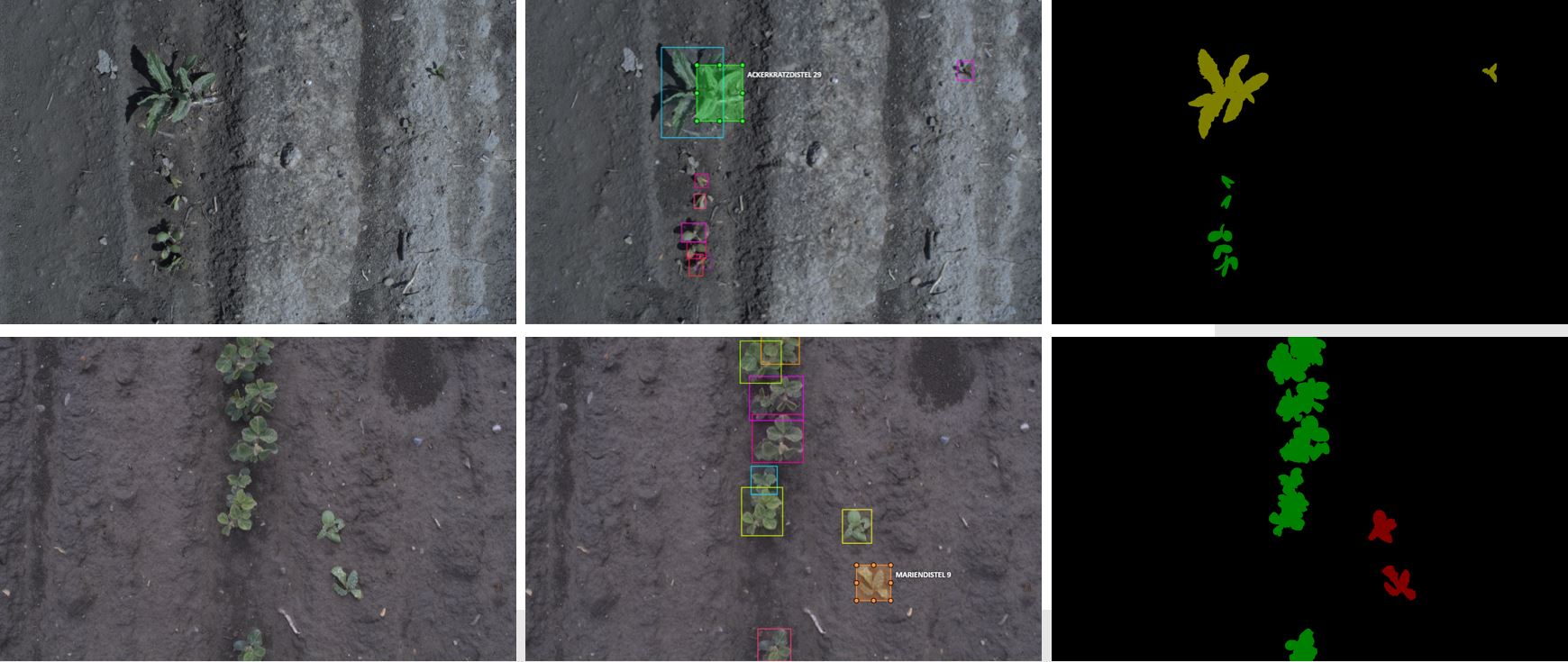

Ein Ziel im Projekt „Integration von Bestandsparameter für intelligente landwirtschaftliche Prozesse“ ist die Erhebung von Pflanzenparametern mittels Bildanalyse. Dabei werden Deep Learning Modelle entwickelt und verwendet, um eine semantische Segmentation des Bildes durchzuführen und Pflanzenspezies zu unterscheiden. Dies kann in der Praxis z.B. für eine Unkrauterkennung herangezogen werden und in eine Planung und Umsetzung einer gezielten Regulierungsmaßnahmen münden. Um die notwendigen Trainingsdaten zur Modellerstellung zu erhalten müssen Bilder aufgenommen und manuell annotiert werden. Je nach Anwendung unterscheidet sich die Annotation und der Aufwand dafür stark. Bei der Klassifikation wird das gesamte Bild einer Klasse zugeordnet. Für die Detektion wird ein rechteckiger Bereich (sogenannte Bounding Box) um ein Objekt markiert. Dabei können auch mehrere Objekte in einem Bild vorkommen. Um eine semantische Segmentierung durchzuführen muss jedes Pixel einer Klasse zugeordnet sein. Bei der Annotation werden Polygone entlang der Objektgrenzen gezeichnet, das Ergebnis kann auch als Segmentationsmaske dargestellt werden. Dabei wird jeder Klasse eine Farbe zugeordnet und jedes Pixel gemäß seiner Klassenzugehörigkeit eingefärbt.

Abbildung 2: Originalbilder im Sojabestand (links), Bounding Box Annotationen (mitte) und Segmentationsmasken (rechts, grün: Sojabohne, gelb: Ackerkratzdistel, rot: Mariendistel, schwarz: Boden) für unterschiedliche Pflanzenstadien (oben, unten). Verwendete Annotationssoftware CVAT [1].

Als Trainingsdaten werden Bilddaten und Annotation gemeinsam als Eingabe verwendet. Beim Training wird das Modell angepasst und optimiert, um einen möglichst geringen Fehler zu den Ground Truth Daten zu erzielen. Die Präzision und Stabilität der erstellten Modelle hängen dabei in hohem Maße von der Qualität der Trainingsdaten und somit auch der durchgeführten Annotationen ab. In der Informatik wird dies mit der Phrase garbage in, garbage out beschrieben. Um zu vermeiden, dass am Ende „Müll“ herauskommt müssen die Trainingsdaten quantitativ und qualitativ gewisse Kriterien erfüllen. Die Auswahl der Bilder muss repräsentativ für die spätere Anwendung sein und eine gewisse Variabilität aufweisen, um eine Verallgemeinerung zuzulassen. Außerdem müssen je nach Komplexität der Modelle mehrere hundert bis mehrere Tausend Bilder aufgenommen und annotiert werden. Da dies ein zeitaufwendiger Prozess ist wird in vielen Bereichen auf bereits existierende Trainingsdatensätze zurückgegriffen.

Gerade für die Anwendung im Bereich des autonomen Fahrens gibt es eine große Anzahl von frei verfügbaren Trainingsdatensätzen, die sehr detaillierte Bildannotationen enthalten. Aufgenommen wurden diese Straßenszenen von an Fahrzeugen montierten Kameras. Die freie Verfügbarkeit dieser Daten ermöglicht es einer breiten Community an anspruchsvollen Forschungsfragen zu arbeiten und einen direkten Vergleich zum Stand der Technik zu ziehen. Dies hat zu einer Beschleunigung der Forschung im Bereich des autonomen Fahrens geführt.

Tabelle 1: Übersicht einer Auswahl von frei verfügbaren Trainingsdatensätzen aus den Anwendungsbereichen autonomes Fahren und Präzisionslandwirtschaft.

|

Datenbank |

Jahr |

Klassen |

Bilder |

Annotationstyp |

Anwendung |

|

KITTI [2] |

2013 |

34 |

400 |

Semantische Segmentation |

Autonomes Fahren |

|

Cityscapes [3] |

2016 |

19 |

5000 |

Semantische Segmentation |

Autonomes Fahren |

|

BDD100K [4] |

2020 |

40 |

10000 |

Semantische Segmentation |

Autonomes Fahren |

|

CWFID [5] |

2015 |

2 |

60 |

Semantische Segmentation |

Karotte vs. Unkraut |

|

Sugar-Beet [6] |

2017 |

2 |

10036 |

Semantische Segmentation |

Zuckerrübe vs. Unkraut |

|

DeepWeeds [7] |

2019 |

9 |

17509 |

Klassifikation |

Unkrauterkennung |

|

Agriculture-Vision [8] |

2020 |

9 |

94986 |

Semantische Segmentation |

Feldanomalie |

Im Bereich der Landwirtschaft gibt es noch eine sehr begrenzte Anzahl von frei verfügbaren Trainingsdaten, die meist für sehr spezielle Anwendungen erhoben wurden und sich in der Art der Aufnahme und Bildsensoren unterscheidet. Der Datensatz Agriculture-Vision umfasst eine sehr große Anzahl von Bildern (RGB+NIR, nahes Infrarot) aus Drohnenflügen um zwischen 9 verschiedenen Feldanomalien wie Nährstoffmangel, Sturmschäden oder Unkrautansammlungen zu unterscheiden. Die beiden Datensätze Sugar-Beet und CWFID (Crop weed field image dataset) wurden mithilfe des mobilen Feldroboters BoniRob [9] aufgenommen (RGB+NIR). Dabei wurden die Pflanzen beschattet und künstlich beleuchtet. Die Annotation umfasst dabei nur 2 Klassen Zuckerrübe bzw. Karotten und Unkraut. Eine weitere Aufgliederung in verschiedene Unkrautspezies wird nicht vorgenommen. Der DeepWeeds Datensatz umfasst Bilder (RGB) von den am meisten verbreiteten Unkrautarten in Australien. Dabei besteht die Annotation aus einer Klassifikation, jedes Bild besteht also nur aus einer Pflanze.

Diesen Beitrag zitieren als:

F. Kitzler, „Nahrung für Künstliche Intelligenz: Überblick von Trainingsdaten für die Bildanalyse in der Landwirtschaft“. In: DiLaAg Innovationsplattform [Webblog]. Online-Publikation: https://dilaag.boku.ac.at/innoplattform/2020/09/21/nahrung-fur-kunstliche-intelligenz/, 2020.

| [1] | „OpenCV CVAT,“ 10 07 2020. [Online]. Available: https://github.com/opencv/cvat. |

| [2] | A. Geiger, P. Lenz, C. Stiller und R. Urtasun, „Vision meets robotics: The kitti dataset,“ The International Journal of Robotics Research, Bd. 32, p. 1231–1237, 2013. |

| [3] | M. Cordts, M. Omran, S. Ramos, T. Rehfeld, M. Enzweiler, R. Benenson, U. Franke, S. Roth und B. Schiele, „The Cityscapes Dataset for Semantic Urban Scene Understanding,“ in Proc. of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016. |

| [4] | F. Yu, H. Chen, X. Wang, W. Xian, Y. Chen, F. Liu, V. Madhavan und T. Darrell, „BDD100K: A diverse driving dataset for heterogeneous multitask learning,“ in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020. |

| [5] | S. Haug und J. Ostermann, „A Crop/Weed Field Image Dataset for the Evaluation of Computer Vision Based Precision Agriculture Tasks,“ in Computer Vision – ECCV 2014 Workshops, Cham, 2015. |

| [6] | N. Chebrolu, P. Lottes, A. Schaefer, W. Winterhalter, W. Burgard und C. Stachniss, „Agricultural robot dataset for plant classification, localization and mapping on sugar beet fields,“ The International Journal of Robotics Research, Bd. 36, p. 1045–1052, 7 2017. |

| [7] | A. Olsen, D. A. Konovalov, B. Philippa, P. Ridd, J. C. Wood, J. Johns, W. Banks, B. Girgenti, O. Kenny, J. Whinney und others, „DeepWeeds: A multiclass weed species image dataset for deep learning,“ Scientific reports, Bd. 9, p. 1–12, 2019. |

| [8] | M. T. Chiu, X. Xu, Y. Wei, Z. Huang, A. G. Schwing, R. Brunner, H. Khachatrian, H. Karapetyan, I. Dozier, G. Rose und others, „Agriculture-vision: A large aerial image database for agricultural pattern analysis,“ in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020. |

| [9] | A. Ruckelshausen, P. Biber, M. Dorna, H. Gremmes, R. Klose, A. Linz, F. Rahe, R. Resch, M. Thiel, D. Trautz und others, „BoniRob–an autonomous field robot platform for individual plant phenotyping,“ Precision agriculture, Bd. 9, p. 1, 2009. |